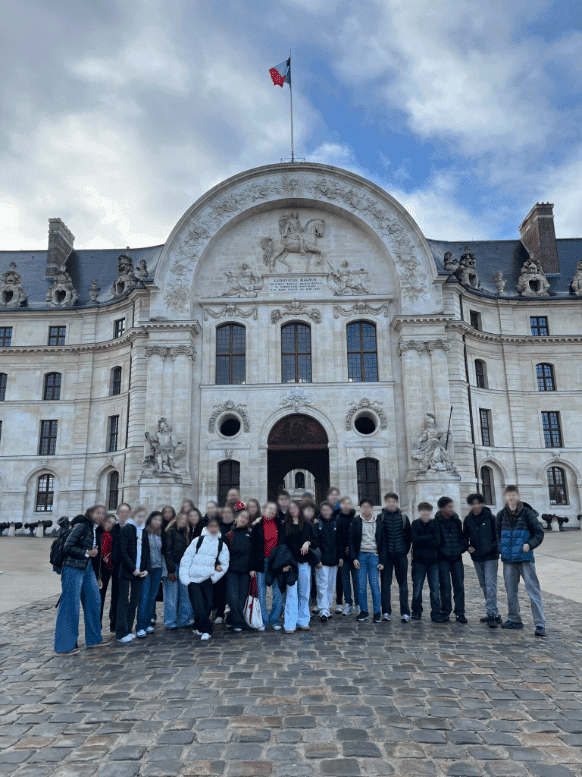

La visite guidée du Musée de l’Air et de l’Espace est une occasion exceptionnelle pour notre classe BIA de réviser le module HISTOIRE et de préparer en douceur l’examen du mois prochain.

Notre histoire aéronautique est très riche et notre guide Charles Pigaillem, médaillé de l’aéronautique, la fait revivre et la pimente d’anecdotes savoureuses : du premier dirigeable électrique « Le France » jusqu’au Goliath Farman premier avion de transport de passagers, nous revivons l’époque héroïque dans le superbe Hall d’Arrivée Art Déco récemment rénové.

Nous continuons notre périple par la rencontre avec des oiseaux mythiques comme le C47 du débarquement du 6 juin 1944, le Boeing 747 et encore les deux Concorde. Une photo sous le ciel bleu devant la fusée ARIANE conclut cette journée bien remplie.